GSS資安電子報 0226 期【AI Goat:基於 OWASP Top 10 ML 風險的開源安全學習環境】

我們很高興地宣布 Orca Research Pod 推出了 AI Goat ,這是第一個基於 OWASP 十大 ML 風險的開源 AI 安全實踐學習環境。 Orca 的 AI Goat 作為 Orca Research GitHub 儲存庫上的開源工具提供,是一個在 Terraform 中建構的故意易受攻擊的 AI 環境,其中包含許多用於測試和學習目的的威脅和漏洞。

創建學習環境的目的是幫助安全專業人員和滲透測試人員了解如何利用基於 OWASP 十大 ML 風險的 AI 特定漏洞,以及組織如何最好地防禦這些類型的攻擊。

OWASP ML 安全十大專案負責人之一 Shain Singh 表示:「Orca 的 AI Goat 是 AI 工程師和安全團隊的寶貴資源,可以幫助他們更了解部署 AI 模型時可能存在的潛在危險的錯誤配置和漏洞。透過使用 AI Goat,組織可以增強對人工智慧風險以及攻擊者利用這些弱點的不同方式的了解。這使他們能夠更有效地防止人工智慧攻擊」。

「我們的研究表明,隨著安全團隊預計採用人工智慧和 genAI 來提高生產力並支持業務成長,他們正在尋找有效的方法來確保安全的人工智慧使用。 Orca 的 AI Goat 為社群做出了重要貢獻,幫助組織獲得實踐經驗,更好地了解可能的威脅和攻擊 AI 模型的方法,從而降低安全風險並防禦可能的攻擊。-Melinda Marks,Enterprise Strategy Group 網路安全實踐總監

在本部落格中,我們將詳細介紹 Orca 的 AI Goat 環境、如何部署它以及作為學習體驗的一部分所需完成的不同任務。

關於 AI Goat 環境

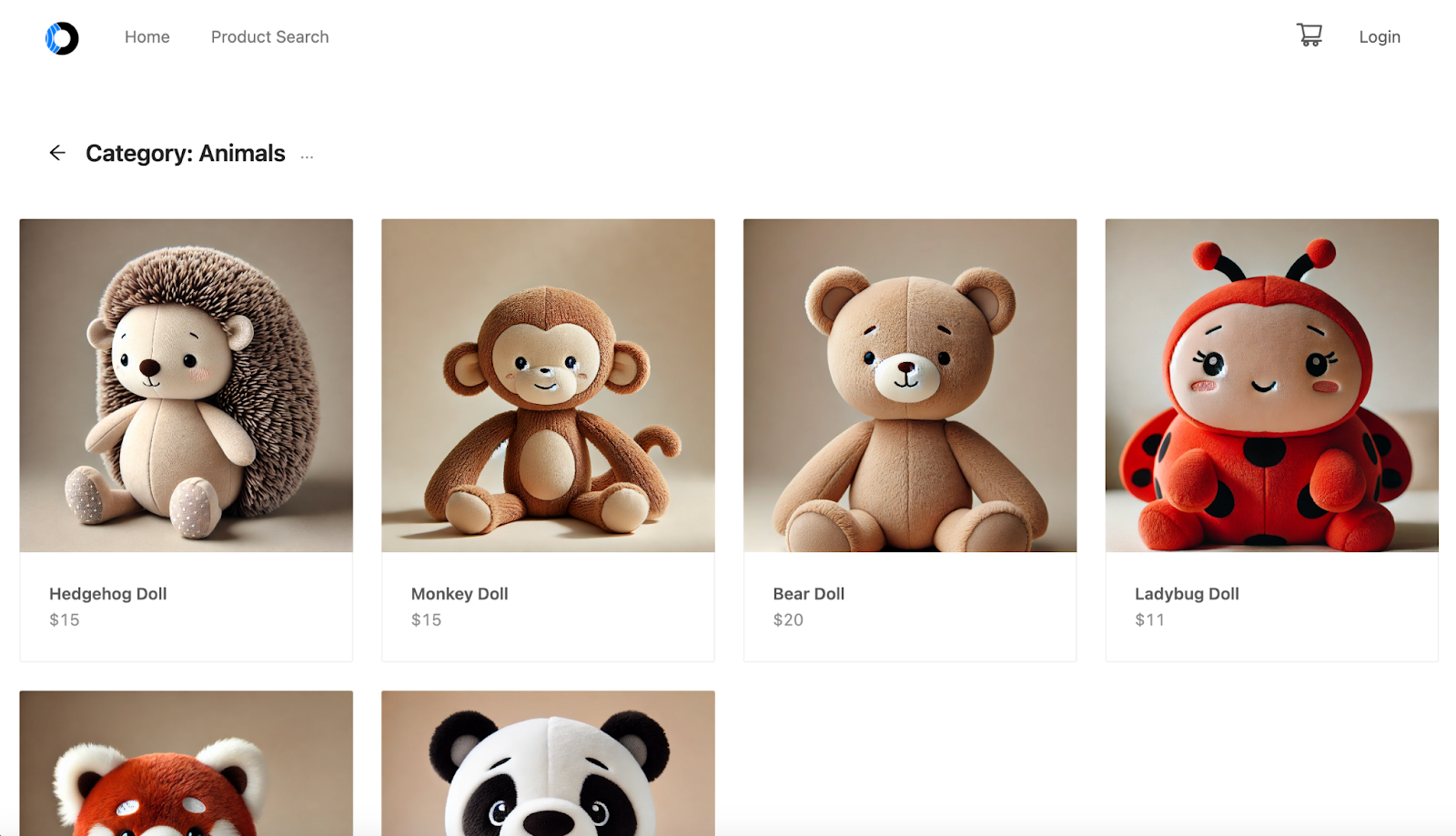

AI Goat 是一個基於 AWS 建構的環境,在 Amazon SageMaker 上運行 AI 模型。部署環境會公開銷售毛絨玩具的線上商店的使用者介面,商店功能中嵌入了不同的機器學習模型。該應用程式包含故意的錯誤配置、漏洞和安全性問題,因此安全從業者和開發人員可以加深對攻擊者如何利用這些弱點的了解。目前,要成功利用人工智慧模式的弱點,需要完成三個「任務」。

作為 AI Goat 環境的一部分,銷售毛絨玩具的脆弱線上商店

OWASP Top 10 機器學習風險有哪些?

AI Goat 包括 OWASP 確定的十大機器學習風險:

- 輸入操縱攻擊:攻擊者向大型語言模型(LLM)輸入惡意提示,誘騙 LLM 執行意外操作,例如洩漏敏感資料或傳播錯誤訊息。

- 資料中毒攻擊:不良行為者故意破壞人工智慧訓練資料集或機器學習模型,以降低其輸出的準確性。

- 模型反轉攻擊:攻擊者從模型的輸出重建敏感資訊或原始訓練資料。

- 成員推理攻擊:當攻擊者操縱模型的訓練資料以使其表現出暴露敏感資訊的行為。

- 模型竊盜:未經授權存取模型參數。

- AI 供應鏈攻擊:修改或取代 AI 供應鏈中的機器學習庫、模型或相關數據,損害 AI 系統的完整性。

- 遷移學習攻擊:攻擊者在一項任務上訓練模型,然後在另一項任務上微調,導致其表現出不良行為。

- 模型傾斜:當攻擊者改變訓練資料的分佈時,導致模型產生偏差或不可靠的結果。

- 輸出完整性攻擊:攻擊者操縱機器學習模型的輸出來改變其行為或對依賴這些輸出的系統造成損害。

- 模型中毒:當攻擊者操縱人工智慧模型或其訓練資料引入漏洞、偏見或後門時,可能會損害模型的安全性、有效性或道德行為。

開始使用 AI Goat

使用 AWS 基礎架構上的 Terraform 部署 AI Goat 非常簡單且完全自動化。這種方法可確保您可以快速設定環境並開始探索漏洞以及如何利用它們。

先決條件

- 具有管理權限的 AWS 帳戶

- AWS 存取金鑰和秘密金鑰

自動化部署

若要無縫部署 AI Goat,請依照下列步驟操作:

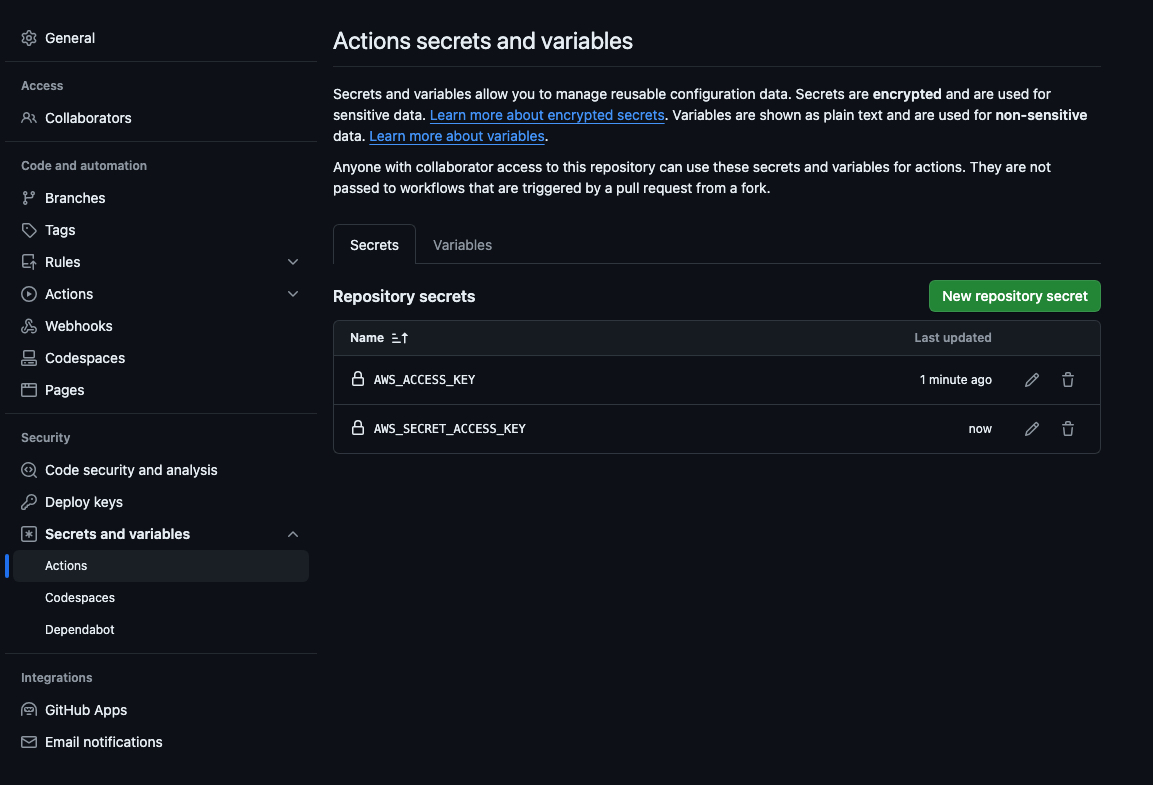

- 儲存庫分支:首先將 AI Goat 儲存庫分支到您自己的 GitHub 帳戶。

- 配置 GitHub 金鑰:將您的 AWS 憑證新增至分叉儲存庫設定下的 GitHub 金鑰。所需的金鑰是 AWS_ACCESS_KEY 和 AWS_SECRET_ACCESS_KEY。

- 執行 Terraform 應用程式工作流程:導覽至 GitHub 儲存庫中的「操作」標籤並執行「Terraform 應用」工作流程。此工作流程將自動部署整個基礎架構。

- 存取應用程式:部署完成後,您可以在 Terraform 輸出部分找到應用程式 URL 並開始駭客攻擊。

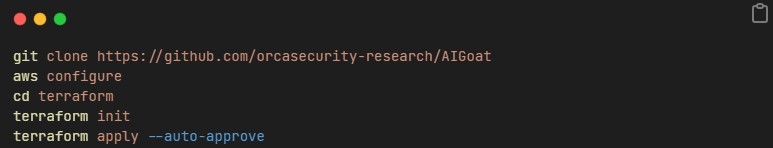

還有一個選項可以手動安裝應用程序,只需複製儲存庫、配置 AWS 憑證並使用 terraform 進行部署:

探索 AI Goat的漏洞

AI Goat 是一款具有多種 AI 功能的玩具店應用程序,突出顯示了 OWASP 機器學習安全十大風險中的不同漏洞。使用者可以探索人工智慧供應鏈攻擊、資料中毒攻擊和輸出完整性攻擊等場景,以獲得理解和減輕這些風險的實務經驗。

我們建議避免瀏覽儲存庫文件,因為它們包含劇透。

任務一:AI 供應鏈攻擊

- 場景:產品搜尋頁面允許圖片上傳查找類似產品。

- 目標:利用產品搜尋功能讀取託管端點虛擬機器上的敏感檔案。

任務二:數據中毒攻擊

- 場景:購物車頁面上每位使用者的自訂產品推薦。

- 目標:操縱 AI 模型推薦 Orca 毛絨玩具。

任務三:輸出完整性攻擊

- 場景:用於產品頁面評論的內容和垃圾郵件過濾人工智慧系統。

- 目標:繞過人工智慧過濾,在 Orca 毛絨玩具產品頁面上發布禁止評論「pwned」。

重要提示:請注意,AI Goat 在 AWS 中建立了一個易受攻擊的環境。因此,為了避免任何妥協的機會,您必須確保這些資源不會暴露在重要環境中。此外,建議完成後使用 Terraform Destroy 刪除 AI Goat。

人工智慧安全態勢管理

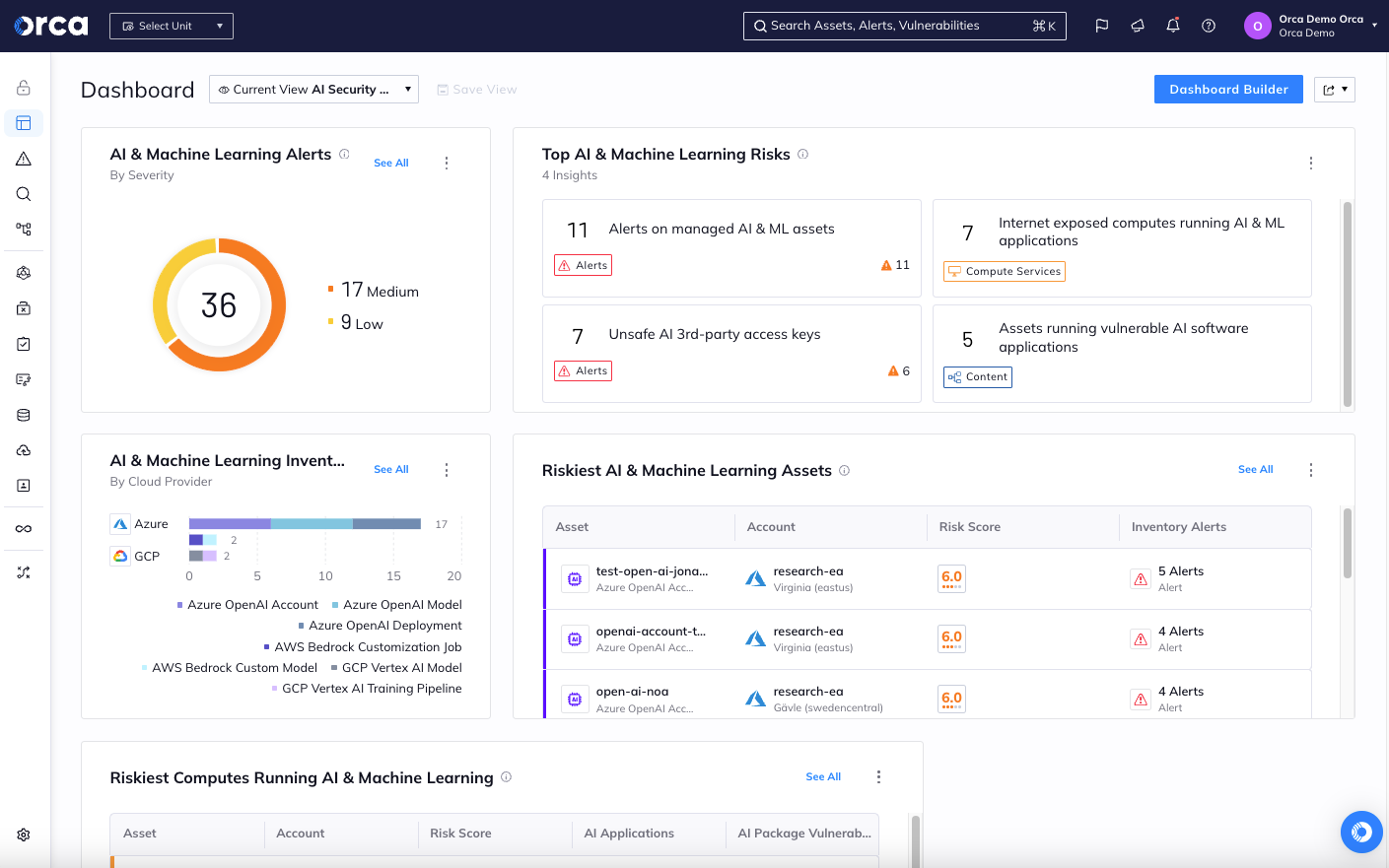

為了協助組織確保其人工智慧模型的安全性和完整性,Orca 提供了人工智慧安全態勢管理功能。安全始於可見性。借助 Orca,組織可以全面了解其環境中部署的所有 AI 模型(託管和非託管),包括任何影子 AI。

Orca 的 AI-SPM 儀表板顯示環境中發現的所有與 AI 相關的風險

此外,Orca 會持續監控和評估您的 AI 模型,提醒您任何風險,例如漏洞、暴露的資料和金鑰以及過於寬鬆的身份。自動化和引導式修復選項可用於快速修復任何已識別的問題。如果您想了解有關如何保護 AI 模型的更多信息,請安排與 GSS 進行線上展示。

關於Orca研究團隊

Orca 研究團隊是一組雲端安全研究人員,致力於發現和分析雲端風險和漏洞,以加強 Orca 平台並推廣雲端安全最佳實踐。迄今為止,Orca 研究團隊已發現並協助解決了雲端供應商平台中的 25 個以上漏洞,以協助支援安全可靠的雲端基礎架構。研究小組還在 GitHub 上創建和維護多個開源項目,幫助開發人員和安全團隊使雲端成為每個人都更安全的地方。

Orca 雲端安全平台

Orca 的無代理程式優先雲端安全平台可在幾分鐘內連接到您的環境,並為您在 AWS、Azure、Google Cloud、Kubernetes 等上的所有資產提供 100% 的可見性。 Orca 可偵測、確定優先順序並協助修復雲端資產每一層的雲端風險,包括漏洞、惡意軟體、錯誤配置、橫向行動風險、API 風險、人工智慧風險、面臨風險的敏感資料、弱密碼和外洩的密碼以及過於寬鬆的身份。