若有任何問題請來信:gss_crm@gss.com.tw

GitHub Copilot 串接 Ollama:地端自託管 LLM,守護企業程式碼資安的 AI 補全解決方案

AI 編程助手(如 GitHub Copilot、ChatGPT)已成為現代開發團隊必備工具。

但對於企業來說,最擔心的就是原始碼外洩:資料送到雲端 AI 推理時,萬一被第三方取得,就可能造成商業機密或客戶資料風險。

傳統 Copilot 只能連接雲端 LLM,所以之前筆者找到 CodeGeex(北京的公司) 及 Continue 的 IDE 插件,都有支援地端 LLM,但使用起來,筆者個人而言,還是 GitHub Copilot 比較順手一點。

但隨著 VSCode 到了 1.99 版增加Bring Your Own Key (BYOK) Preview功能,現在Copilot 終於能連接本地地端 Ollama 的 LLM,讓企業可以完全掌控推理資料流,原始碼不離開本地/內網,兼顧效率與資安。

Copilot 串接地端 Ollama LLM

設定 Ollama

安裝好 Ollama 後,開啟命令視窗,執行ollama serve 把服務跑起來,開啟網頁連到http://localhost:11434/ 會顯示 Ollama is running。

再另開一個命令視窗,執行ollama pull phi4-mini,下載要使用的 Model(這裡以 phi4-mini 為例)。

設定 GitHub Copilot

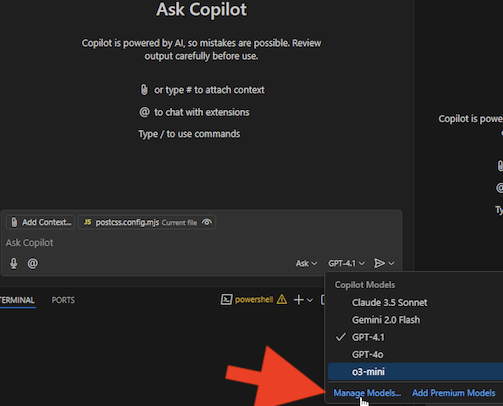

下載好模型後,打開 VSCode,於 GitHub Copilot 對話視窗最下方的模型切換選單中,點選**Manage Models…**,如下圖:

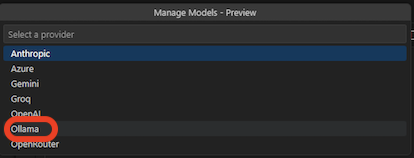

然後選擇Ollama,如下圖:

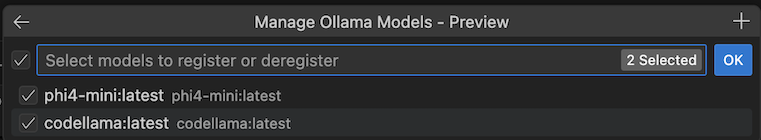

然後就會列出可以使用的 Model,如下圖:

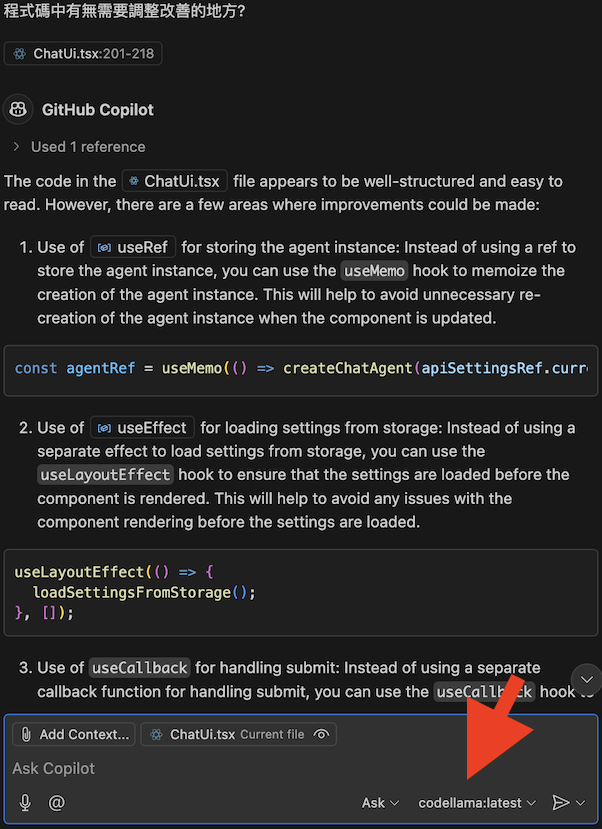

接下來回到 GitHub Copilot 對話視窗,將模型切換為 phi4-mini 或 codellama,即可開始使用 AI 助手。此時 Copilot 補全將透過本地 LLM 運算,程式碼資料只會流向你自己的電腦/內網,不會外洩到外部雲端。如下圖:

設定遠端 Ollama LLM

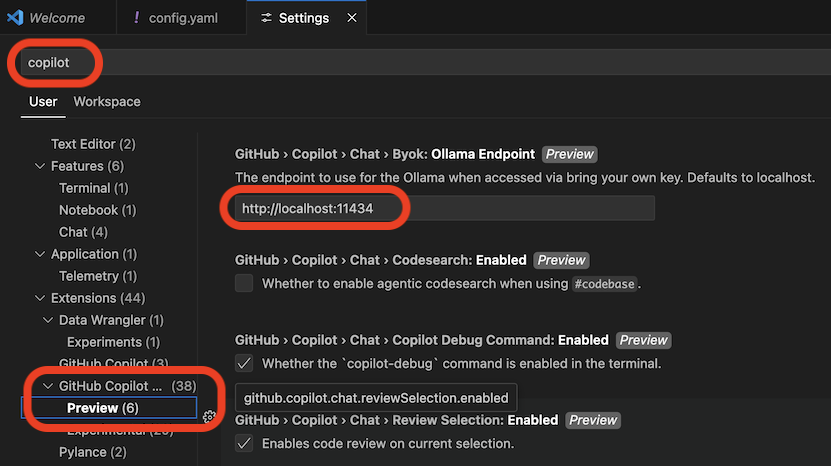

如果你有遠端 Ollama 服務(例如公司有統一的 GPU Server),可以設定 GitHub Copilot 遠端 Ollama 的 URL,如下圖:

在設定中,輸入 copilot 在 GitHub Copilot Chat -> Preview -> Ollama Endpoint

參考資源

VS Code Bring Your Own Key (BYOK) Preview

Ollama

CodeGeex(北京的公司)

Continue

When you subscribe to the blog, we will send you an e-mail when there are new updates on the site so you wouldn't miss them.

評論